वीडियो: क्या सिग्मॉइड ReLU से बेहतर है?

2024 लेखक: Lynn Donovan | [email protected]. अंतिम बार संशोधित: 2023-12-15 23:47

रेलु : गणना करने के लिए अधिक कम्प्यूटेशनल रूप से कुशल सिग्मॉइड की तुलना में कार्यों की तरह रेलु केवल अधिकतम (0, x) चुनने की आवश्यकता है और सिग्मोइड्स के रूप में महंगे घातीय संचालन नहीं करना चाहिए। रेलु : व्यवहार में, नेटवर्क के साथ रेलु दिखाने के लिए प्रवृत्त बेहतर अभिसरण प्रदर्शन थानसिग्मॉइड.

इसी तरह कोई पूछ सकता है कि ReLU सबसे अच्छा एक्टिवेशन फंक्शन क्यों है?

मुख्य विचार यह है कि ग्रेडिएंट को शून्य न होने दें और अंततः प्रशिक्षण के दौरान ठीक हो जाएं। रेलु tanh की तुलना में कम कम्प्यूटेशनल रूप से महंगा है और अवग्रह क्योंकि इसमें सरल गणितीय संक्रियाएं शामिल हैं। वह अच्छा जब हम डीप न्यूरलनेट डिजाइन कर रहे होते हैं, तो इस पर विचार करना चाहिए।

कोई यह भी पूछ सकता है कि सिग्मॉइड सक्रियण कार्य क्या है? NS सिग्मॉइड फ़ंक्शन एक है सक्रियण समारोह तंत्रिका नेटवर्क में न्यूरॉन्स फायरिंग के सह-संबंध में संरचित अंतर्निहित गेट के संदर्भ में। व्युत्पन्न, भी कार्य करता है a सक्रियण समारोह न्यूरॉन को संभालने के मामले में सक्रियण एनएन के संदर्भ में। Thetwo के बीच का अंतर है सक्रियण डिग्री और परस्पर क्रिया।

इसी तरह, हम CNN में ReLU का उपयोग क्यों करते हैं?

संवादात्मक तंत्रिका नेटवर्क ( सीएनएन ): चरण 1(बी) - रेलु परत। रेक्टिफाइड लीनियर यूनिट, या रेलु , है दृढ़ तंत्रिका नेटवर्क की प्रक्रिया का एक अलग घटक नहीं है। रेक्टिफायर फ़ंक्शन को लागू करने का उद्देश्य है हमारी छवियों में गैर-रैखिकता बढ़ाने के लिए।

रेएलयू का उपयोग क्या है?

रेलु (रेक्टिफाइड लीनियर यूनिट) एक्टिवेशन फंक्शन The रेलु सबसे अधिक है उपयोग किया गया अभी दुनिया में सक्रियण कार्य। चूंकि, यह है उपयोग किया गया लगभग सभी दृढ़ तंत्रिका नेटवर्क या गहन शिक्षण में।

सिफारिश की:

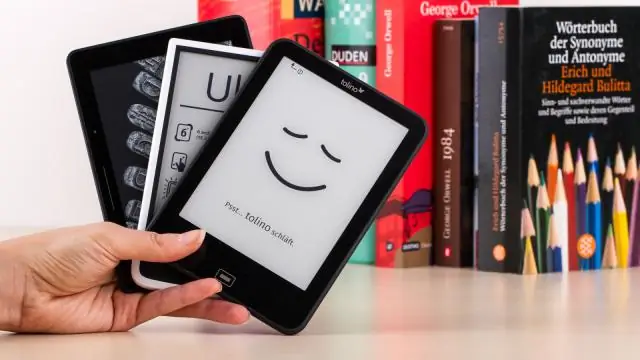

क्या ई पाठक किताबों से बेहतर हैं?

2. ई-बुक्स प्रिंट से ज्यादा पोर्टेबल हैं। मुद्रित पुस्तकें, विशेष रूप से हार्डबाउंड संस्करण, बहुत भारी हो सकते हैं, जबकि अधिकांश आधुनिक ई-रीडर उपकरण हल्के होते हैं। कुछ भौतिक पुस्तकें लाने की तुलना में शीर्षकों की एक संपूर्ण लाइब्रेरी वाले ई-रीडर को ले जाना कहीं अधिक आसान है

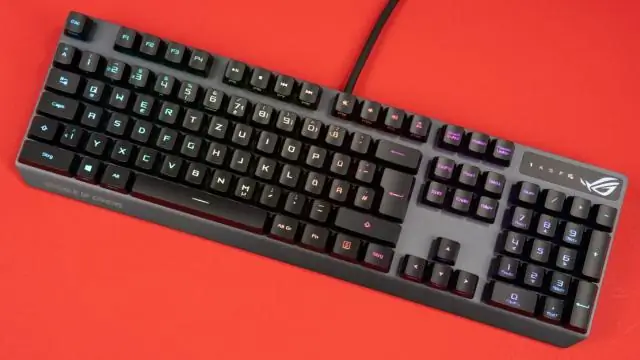

क्या घुमावदार कीबोर्ड बेहतर हैं?

लंबे समय में, एर्गोनोमिक कीबोर्ड पर टाइप करना बेहतर लगता है, आपकी बाहें कम थकती हैं, और आप तेजी से और अधिक सटीक रूप से टाइप कर सकते हैं। इसके अलावा, आप दोहराए जाने वाले तनाव की चोटों (आरएसआई) को कम करेंगे जहां आप टाइपिंग से मांसपेशियों, टेंडन और तंत्रिकाओं को नुकसान पहुंचा सकते हैं।

क्या मुझे बेहतर कैमरा या बेहतर लेंस खरीदना चाहिए?

मेरी राय में, वित्तीय निवेश के संबंध में, एक गुडलेंस बेहतर विकल्प है क्योंकि यह आपको शरीर की तुलना में अधिक समय तक टिकेगा (जैसा कि आप आम तौर पर लेंस की तुलना में तेजी से कैमराबॉडी बदल रहे होंगे)। दूसरी ओर, वही लेंस, अब से पांच से 10 साल बाद भी उपयोग किए जाने की संभावना है (यदि अधिक समय तक नहीं)

क्या एनालॉग स्केल डिजिटल से बेहतर हैं?

यदि आप अपने शरीर के वजन को रिकॉर्ड करने के लिए एक पैमाना चाहते हैं, तो एक एनालॉग या डिजिटल पैमाना पर्याप्त है। Digitalscales ज्यादातर बहुत सटीक और सटीक होते हैं। दूसरे, डिजिटल स्केल वेटरीडिंग की बेहतर पठनीयता प्रदान करते हैं। इसके अलावा, डिजिटल पैमानों में एक मेमोरी फ़ंक्शन होता है जिसका उपयोग पिछले मापों को संग्रहीत करने के लिए किया जा सकता है

सिग्मॉइड एसिम्प्टोट का मान कहाँ करता है?

उत्तर: सिग्मॉइड फ़ंक्शन में दो क्षैतिज अनंतस्पर्शी होते हैं, y=0 और y=1. फ़ंक्शन को x के प्रत्येक बिंदु पर परिभाषित किया गया है। तो इसका कोई लंबवत स्पर्शोन्मुख नहीं है