वीडियो: सेल्फ अटेंशन कैसे काम करता है?

2024 लेखक: Lynn Donovan | [email protected]. अंतिम बार संशोधित: 2023-12-15 23:47

आम आदमी के शब्दों में, स्वयं - ध्यान तंत्र इनपुट को एक दूसरे के साथ बातचीत करने की अनुमति देता है (" स्वयं ”) और पता करें कि उन्हें किसे अधिक भुगतान करना चाहिए ध्यान प्रति (" ध्यान ”)। आउटपुट हैं इन इंटरैक्शन के समुच्चय और ध्यान अंक

इसके अलावा, आत्म ध्यान क्या है?

स्वयं - ध्यान , जिसे कभी-कभी इंट्रा- कहा जाता है ध्यान एक ध्यान अनुक्रम के प्रतिनिधित्व की गणना करने के लिए एक ही अनुक्रम के विभिन्न पदों से संबंधित तंत्र।

इसके अलावा, गहन शिक्षा में आत्म ध्यान क्या है? सबसे पहले, आइए परिभाषित करें कि क्या " स्वयं - ध्यान " है। चेंग एट अल, "लॉन्ग शॉर्ट-टर्म मेमोरी-नेटवर्क्स के लिए" नाम के अपने पेपर में मशीन पढ़ना", परिभाषित स्वयं - ध्यान अधिक विशद प्रतिनिधित्व प्राप्त करने के लिए एकल अनुक्रम या वाक्य के विभिन्न पदों से संबंधित तंत्र के रूप में।

इस बारे में अटेंशन मैकेनिज्म क्या है?

ध्यान तंत्र डिकोडर को आउटपुट पीढ़ी के प्रत्येक चरण में स्रोत वाक्य के विभिन्न भागों में भाग लेने की अनुमति देता है। इनपुट अनुक्रम को एक निश्चित संदर्भ वेक्टर में एन्कोड करने के बजाय, हम मॉडल को यह सीखने देते हैं कि प्रत्येक आउटपुट समय चरण के लिए एक संदर्भ वेक्टर कैसे उत्पन्न किया जाए।

अटेंशन बेस्ड मॉडल क्या है?

ध्यान - आधारित मॉडल के एक वर्ग से संबंधित हैं मॉडल आमतौर पर अनुक्रम-से-अनुक्रम कहा जाता है मॉडल . इनका उद्देश्य मॉडल , जैसा कि नाम से पता चलता है, यह एक इनपुट अनुक्रम दिए गए आउटपुट अनुक्रम का उत्पादन करने के लिए है, जो सामान्य रूप से, विभिन्न लंबाई के होते हैं।

सिफारिश की:

काम चालू करने के लिए आप जिन लैंप को छूते हैं, वे कैसे काम करते हैं?

इसका मतलब यह है कि अगर कोई सर्किट लैंप को इलेक्ट्रॉनों से चार्ज करने की कोशिश करता है, तो उसे 'भरने' के लिए एक निश्चित संख्या की आवश्यकता होगी। जब आप दीपक को छूते हैं, तो आपका शरीर अपनी क्षमता में इजाफा करता है। आपको और लैंप को भरने के लिए अधिक इलेक्ट्रॉनों की आवश्यकता होती है, और सर्किट उस अंतर का पता लगाता है

फ्रैंकिंग क्रेडिट क्या हैं और वे कैसे काम करते हैं?

ऑस्ट्रेलियाई कर प्रणाली कंपनियों को भुगतान किए गए लाभांश के साथ संलग्न करने के लिए फ्रैंकिंग क्रेडिट के अनुपात को निर्धारित करने की अनुमति देती है। एक फ्रैंकिंग क्रेडिट लाभांश आरोपण का उपयोग कर कंपनियों द्वारा भुगतान की गई कर की एक मामूली इकाई है। फ्रैंकिंग क्रेडिट शेयरधारकों को लाभांश के साथ दिया जाता है

बिल्ट इन सेल्फ टेस्ट का क्या मतलब है?

बिल्ट-इन सेल्फ-टेस्ट (BIST) या बिल्ट-इन टेस्ट (BIT) एक ऐसा तंत्र है जो मशीन को खुद का परीक्षण करने की अनुमति देता है। उच्च विश्वसनीयता जैसी आवश्यकताओं को पूरा करने के लिए इंजीनियर BISTs को डिज़ाइन करते हैं। कम मरम्मत चक्र समय

पायथन में सेल्फ __ क्लास __ क्या है?

स्वयं। _class_ वर्तमान उदाहरण के प्रकार का संदर्भ है। सार 1 के उदाहरणों के लिए, वह सार 1 वर्ग ही होगा, जो कि आप एक अमूर्त वर्ग के साथ नहीं चाहते हैं

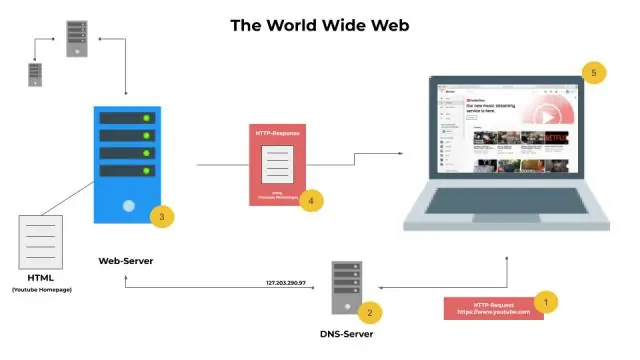

आईटी इन्फ्रास्ट्रक्चर कौन से घटक बनाते हैं और वे एक साथ कैसे काम करते हैं?

आईटी इन्फ्रास्ट्रक्चर में वे सभी तत्व होते हैं जो डेटा और सूचना के प्रबंधन और उपयोगिता का समर्थन करते हैं। इनमें एक उद्यम के व्यावसायिक लक्ष्यों का समर्थन करने के लिए भौतिक हार्डवेयर और सुविधाएं (डेटा केंद्रों सहित), डेटा भंडारण और पुनर्प्राप्ति, नेटवर्क सिस्टम, विरासत इंटरफेस और सॉफ़्टवेयर शामिल हैं।